(di antonio e armando) – Le ricerche sull’Intelligenza Artificiale stanno attraversando un periodo rivoluzionario. Occorre, prima di procedere, fare delle considerazioni storiche sull’IA per poi valutarne i limiti ed i confini.

Teoria della computazione

Alla domanda “Può una macchina pensare?” diversi teorici hanno fornito nel tempo molte ragioni per dare una risposta affermativa. Una delle prime e più profonde stava in due importanti risultati della teoria della computazione. La prima è la tesi di Church, secondo cui ogni funzione che sia effettivamente calcolabile è ricorsivamente computabile. Effettivamente calcolabile significa che esiste una procedura “meccanica” per determinare, in un tempo finito, il valore o l’uscita della funzione per un dato argomento od ingresso. Ricorsivamente computabile significa in particolare che esiste un insieme finito di operazioni aritmetiche elementari che, applicate ad un dato argomento e poi ai risultati successivi di queste elaborazioni, consente di ottenere il valore della funzione in un tempo finito.

Macchina manipolatrice di simboli e test di Turing

L’altro risultato importante è la dimostrazione di Alan Turing, secondo cui ogni funzione ricorsivamente computabile può essere calcolata in un tempo finito da un tipo semplice di macchina manipolatrice di simboli, detta successivamente macchina universale di Turing (MS). Essa è governata da un insieme di regole applicabili ricorsivamente, in grado di considerare l’identità, l’ordine e la disposizione dei simboli elementari in ingresso via via incontrati.

Questi due risultati comportano una conseguenza notevole: un calcolatore digitale tradizionale, purché abbia il programma giusto, una memoria abbastanza grande e tempo a sufficienza, può calcolare qualsiasi funzione tra ingresso ed uscita governata da regole. In particolare, i risultati comportano che una macchina manipolatrice di simboli (MS) adeguatamente programmata dovrebbe riuscire a superare il test di Turing per l’intelligenza cosciente. Nella versione originale del test di Turing, ciò che si introduce nella macchina MS sono domande ed osservazioni tipiche di una conversazione, battute su una tastiera da una persona qualsiasi, mentre le uscite sono riportate dattiloscritte, fornite dalla macchina MS. La macchina supera questo test per l’intelligenza se le sue risposte non possono essere distinte dalle risposte dattiloscritte di una persona umana. Naturalmente, al momento, nessuno conosce la funzione che produrrebbe in uscita il comportamento di una persona pensante, ma Church e Turing garantiscono che, qualsiasi sia questa funzione, una macchina MS adeguata potrebbe computarla. Una tale conclusione è importante, soprattutto perché l’interazione svolta solo mediante telescrivente ipotizzata da Turing è un vincolo superfluo.

Macchina manipolatrice di simboli e cervello

La stessa conclusione si ottiene anche se la macchina MS interagisce con il mondo esterno in modi più complessi: mediante visione diretta, o con dialoghi veri e propri ed altro ancora. L’unico problema che resta è quello di identificare la funzione complessa che governa la struttura delle risposte umane all’ambiente e poi scrivere il programma. Le macchine MS fornite di buoni programmi svolgono un’ampia gamma di attività cognitive, seguono istruzioni complicate, risolvono complessi problemi. L’Intelligenza Artificiale classica, basata sulla stesura di programmi, ha rappresentato un complesso di ricerche impegnative e riuscite sotto molti punti di vista. Naturalmente, vi sono lati oscuri. Intanto, è evidente che le macchine MS non sono molto simili al cervello. Ma anche qui l’impostazione classica fornisce una risposta convincente. Innanzitutto, il materiale con cui una qualsiasi macchina MS è costruita non ha niente a che fare con la funzione calcolata, che è fissata dal programma. In secondo luogo, anche i particolari costruttivi dell’architettura funzionale della macchina sono irrilevanti, poiché architetture differenti potrebbero determinare la stessa funzione ingresso-uscita. Di conseguenza, l’Intelligenza Artificiale ha cercato di trovare la funzione ingresso-uscita caratteristica dell’intelligenza ed il programma più efficace per calcolarla.

Agli inizi degli anni ’70, Dreyfus ha criticato le simulazioni dell’attività cognitiva, giudicandole insufficienti rispetto alla realtà cognitiva ed imputava a queste simulazioni un difetto sistematico. Ciò che mancava era il vasto cumulo di conoscenze di base inarticolate che ogni persona possiede e la capacità di usare il buon senso per sfruttare gli aspetti utili di tali conoscenze al mutare delle circostanze. Sempre in questo periodo, il tasso di rendimento cognitivo comincia a diminuire all’aumentare della velocità e della memoria. Per simulare il riconoscimento degli oggetti da parte del sistema visivo, si deve ricorrere ad una potenza di calcolo di livello inaspettato. I tempi di calcolo sono sempre più lunghi, molto di più di quelli richiesti da un sistema visivo reale. Tale lentezza è incomprensibile, poiché in un calcolatore la propagazione dei segnali è un milione di volte più veloce che nel cervello, ad una frequenza di clock di centinaia di Mhz. Eppure, nei problemi reali, la tartaruga supera la lepre.

Negli anni ’80, John Searle ha concepito una critica abbastanza nuova, indirizzata all’assunto di fondo del programma di ricerca classico: ovvero, l’idea che una manipolazione adeguata di simboli strutturali tramite l’applicazione ricorsiva di regole che tengano conto della struttura possa produrre un’intelligenza cosciente. Searle si basa su un esperimento concettuale avente due caratteristiche fondamentali. In primo luogo, la macchina MS deve attuare una funzione ingresso-uscita capace di sostenere una conversazione superando il test di Turing. In secondo luogo, la struttura interna della macchina è tale che, comunque essa si comporti, un osservatore abbia la certezza che né la macchina, né alcuna sua parte capisce il linguaggio discorsivo.

Tutto ciò che la macchina contiene è una persona che parla solo l’inglese e che seguendo una serie di istruzioni scritte manipola i simboli cinesi che entrano ed escono. In breve, il sistema dovrebbe superare il test di Turing, pur non comprendendo né il cinese né il vero contenuto semantico del cinese. La conclusione generale di Searle è che un sistema che si limiti a manipolare simboli fisici che tengano conto della struttura sarà al massimo una vuota parodia dell’autentica intelligenza cosciente, poiché è impossibile generare la vera semantica semplicemente macinando una vuota sintassi. Gli elementi dell’intelligenza cosciente devono possedere un contenuto semantico reale.

Nuove tendenze dell’IA verso Emulatori che riproducano il funzionamento del cervello

Il problema dell’intelligenza cosciente rimane irrisolto secondo le linee di ricerca dell’IA classica. L’architettura funzionale delle macchine MS classiche non è adatta a svolgere compiti molto impegnativi.

Le nuove tendenze dell’IA sono rivolte alla conoscenza approfondita del cervello biologico ed alla costruzione di una nuova classe di modelli computazionali che si ispirano alla sua struttura. Sono soprattutto due le caratteristiche anatomiche per cui il cervello si differenzia profondamente dall’architettura dei calcolatori elettronici tradizionali.

In primo luogo, il sistema nervoso è una macchina parallela, nel senso che i segnali sono elaborati simultaneamente in miliardi di canali diversi. La retina, ad esempio, presenta al cervello il suo complicato ingresso non in blocchi di 8, 16 o 32 elementi, come in un calcolatore da tavolo, bensì sotto forma di quasi un milione di segnali distinti che arrivano simultaneamente all’estremità del nervo ottico, il nucleo genicolato laterale, dove vengono elaborati collettivamente e simultaneamente.

Strutture parallele

I modelli a rete semplificati sono utili per capire come potrebbero funzionare le reti di neuroni reali e per rilevare le proprietà comportamentali delle architetture parallele. In una rete a strati dove ogni neurone di uno strato è collegato a tutti i neuroni dello strato successivo mediante assoni, uno stimolo in ingresso produce un dato livello di attivazione in una certa unità di ingresso, la quale mediante il suo assone trasmette alle molte connessione sinaptiche che collegano le unità nascoste un’adeguata frequenza di segnali proporzionale al livello di attivazione. L’effetto complessivo è che un fronte di attivazione nell’insieme delle unità di ingresso produce un fronte di attivazione nell’insieme delle unità nascoste. Un fronte di attivazione delle unità nascoste produce un fronte di attivazione perturbato dal proprio stato nelle unità di uscita. Il fronte di uscita è oramai diverso, avendo subito, nel passaggio, una modifica. “L’elaborazione”, in questo caso, è una propria e vera “trasformazione”. Il messaggio trasmesso dalla trasformazione del fronte è una sorta di “firma” dell’istante-processo.

Vantaggi di una struttura parallela rispetto al calcolatore

Per quanto semplifichi la struttura del cervello, il modello a rete presenta notevoli vantaggi importanti.

Innanzitutto, un’architettura parallela consente un aumento radicale di velocità rispetto ad un calcolatore convenzionale, perché le numerose unità, per ogni strato, compiono molte piccole operazioni simultanee invece che in faticosa successione. Questo vantaggio aumenta di importanza quando il numero di unità di ciascuno strato aumenta.

In secondo luogo, un elevato grado di parallelismo comporta che il sistema resista ad eventuali piccoli danni mantenendo la propria funzionalità. La perdita di alcuni collegamenti ha un effetto trascurabile sul carattere della trasformazione complessiva dalla parte rimanente della rete.

In terzo luogo, un sistema parallelo immagazzina grandi quantità di informazione in modo distribuito.

L’elaborazione parallela non è l’ideale per ogni tipo di calcolo. Con operazioni che richiedono soltanto un piccolo vettore in ingresso, con poche componenti, ma molti milioni di calcoli ricorsivi in rapida interazione, il cervello, come struttura parallela, lavora molto male, mentre le macchine MS tradizionali eccellono.

Esiste tuttavia un’altrettanta estesa classe computazionale per la quale l’architettura del cervello è la migliore. Si tratta delle elaborazioni che in genere devono affrontare gli esseri viventi, come ad esempio riconoscere la sagoma di una persona in un ambiente disturbato, e ricordare successivamente ed all’istante la sagoma stessa. Sono elaborazioni che presentano un numero elevato di ingressi, con altrettanti canali, ma il risultato viene ottenuto con trasformazioni relativamente semplici.

Il cervello non può essere considerato solamente come una semplice macchina parallela con un elevato grado di architettura, ma anche sede dell’immaginazione e di memoria pregressa derivante da tutti i sistemi sensoriali.

L’Enea verso la realizzazione di Olocontrollo Emulativo

L’Unità RIN di Frascati, nello stesso periodo, in stretta collaborazione con Oberon srl ed altri, nell’ambito delle attività di Ricerca e Sviluppo dell’Intelligenza Artificiale, iniziava ad idealizzare un modello di architettura parallela delle macchine, che si avvicinasse maggiormente al funzionamento delle macchine biologiche.

Ha preso così il via operativo lo svolgimento realizzativo di un progetto destinato a riaprire, da principio, il discorso sull’automazione industriale, ed in prospettiva ad oltrepassare i cancelli della fabbrica per invadere la vita di tutti i giorni nell’ambito dei servizi e delle utilità sociali.

Si tratta della ricerca, dello sviluppo e dell’applicazione di una nuova “filosofia tecnologica” che, avvalendosi delle nuove conoscenze neurobiologiche, ne riproduce alcune capacità elaborative.

L’idea ha portato alla concretizzazione di Olocontrollo Emulativo, che nella attuale fase di avanzamento ha prodotto numerose applicazioni industriali, quali macchine utensili transfer a 44 assi, macchine laser ad alta potenza continua (Fincantieri e Riva Techint), macchine di manipolazione per montaggio e formatura (Ibs, Giuliani), sistema di controllo ambientale via visione sintetica (“visio”) per siti archeologici e musei (Stacchiotti Impianti), dispositivo di supplenza percettiva per non vedenti (“visio”), ecc. Olocontrollo Emulativo, per mezzo di nuovo hardware e nuovo software, permette di realizzare un sistema di controllo universale per i robots industriali, rigenerandone l’operatività con l’introduzione di una sorta di “capacità riflessiva”. Alla macchina, attualmente configurata come una struttura cinematica e dinamica complessa integrata di tutto il repertorio elettrotecnico, elettronico e softwaristico convenzionale, viene innestata un’ulteriore fase di “intelligenza”: un fronte profondo costituito da “realtà virtuale” (EMULAZIONE) sul quale va imprimendosi e poi riflettendosi la “realtà concreta” sotto forma di stimoli sensoriali e comandi attuatori.

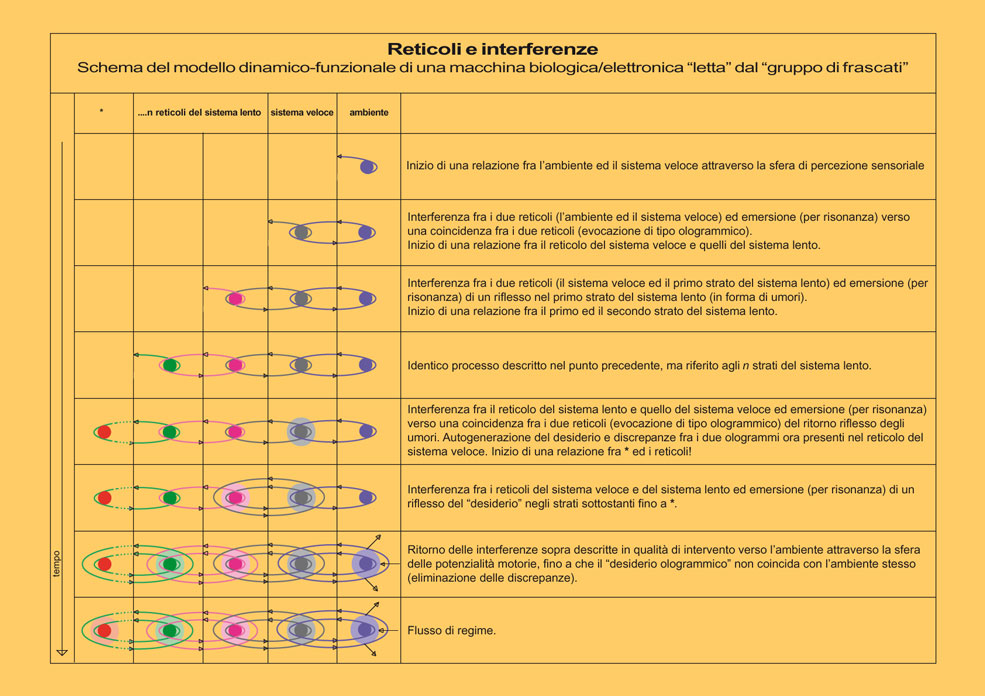

Il modello di Olocontrollo Emulativo

Il modello usato è composto da una macchina completa della sua struttura cinematica e da una corrispondente ricostruzione virtuale all’interno di uno spazio virtuale ad n dimensioni. Questi due oggetti (il concreto ed il virtuale) sono separati da una “parete elettronica” (Olocontrollo), che da un lato presenta caratteristiche concrete ed è collegata alla macchina concreta con una serie di canali di ingresso (sensori) e di uscita (attuatori), mentre dall’altro lato è collegata alla macchina virtuale con una serie di canali di ingresso (sensori) e di uscita (attuatori) virtuali. Olocontrollo è la sezione che realizza pienamente le trasduzioni fra la parte fisica e quella virtuale dei singoli canali nelle due direzioni (reversibilità).

La funzionalità del modello è tale che una qualunque modificazione in uno dei due ambienti, attraverso i canali, si riflette nell’altro che è così costretto ad inseguirlo.

Dall’ambiente all’emulatore

L’architettura parallela del sistema è tradotta nella realizzazione di una moltitudine di canali fisici che rappresentano i vettori di ingresso del sistema intelligente. Ogni canale fisico ha associata una variabile di controllo. I numerosi canali di ingresso disponibili possono essere utilizzati da altrettanti sensori d’ambiente (da quelli di visione con CCD a quelli LASER, dai fine corsa ai sensori di prossimità o a quelli ad Ultrasuoni). L’emulatore, nel suo interno, ha ricostruito virtualmente l’ambiente esterno completo delle variabili interessanti il processo produttivo (spazi, macchine, stati fisici, ecc.), nonché l’insieme virtuale dei canali fisici di ingresso e i collegamenti fra canali virtuali e canali fisici. Le modificazioni dinamiche ambientali, attraverso il fronte costituito dal sistema sensoriale e attraverso l’insieme virtuale dei canali fisici, entrano nello spazio emulato del sistema e, imprimendosi nel suo interno, lo aggiornano continuamente. L’emulatore acquisisce una piena conoscenza del mondo circostante e dei suoi aggiornamenti.

Dall’emulatore all’ambiente

L’emulatore, nel suo interno, ha ricostruito anche l’insieme virtuale dei canali fisici di uscita e i relativi collegamenti. Il fronte dei canali di uscita rappresenta l’insieme dei comandi attuatori del sistema verso l’ambiente. Ogni canale fisico ha associata una variabile controllata. L’insieme delle variabili controllate costituisce l’insieme dei vettori di uscita che determinano le modificazioni dell’ambiente concreto.

L’indipendenza tra le diverse variabili

Quando un vettore entra nel sistema usando una specifica connessione di ingresso, viene trasformato nel corso del suo passaggio fino alla connessione di uscita.

Ogni canale fisico è caratterizzato dall’assenza di accoppiamenti di vario genere, che rappresentano i disturbi al sistema, e dalla totale indipendenza tra le diverse variabili di controllo. Il sistema di controllo finale, che considera in sé il processo stesso da controllare, risulta essere disaccoppiato, nel senso che ogni variabile di uscita del sistema è influenzata solamente dalla propria variabile di ingresso o di controllo e non da altre. In sostanza, ogni variabile di ingresso controlla la propria variabile di uscita.

La dinamica del mondo emulativo

L’ambiente concreto, come già accennato, si affaccia verso Olocontrollo con un piano di sensori che producono di fatto un fronte di segnali che nel loro insieme trasferiscono la sintesi dello stato istantaneo dello stesso ambiente concreto. Ad ogni variazione dello stato concreto si avrà una variazione del fronte che, attraverso Olocontrollo, raggiungerà gli ingressi virtuali all’Emulatore ove si coniugheranno con un primo livello di modelli virtuali molto semplici (minimi termini), ognuno dei quali, rappresentando il singolo sensore, verrà aggiornato allo stato attuale dei sensori concreti. Avremo così una condizione di costante aggiornamento all’uguaglianza (inseguimento unidirezionale) tra il fronte di uscita del concreto con il fronte di ingresso del virtuale; in tal modo otteniamo lo svincolo (liberazione) dal concreto stesso per poter vivere nel solo virtuale i processi che seguiranno.

Proseguendo verso l’interno dell’Emulatore, troviamo un piano successivo nel quale sono definiti altri modelli virtuali costituiti dall’aggregazione dei precedenti e rappresentanti altrettanti oggetti funzionanti del concreto. Questa volta, il fronte di segnali che partono dal primo livello conduce all’aggiornamento dei modelli del livello successivo (un asse è in una nuova posizione, un cilindro pneumatico è al fine corsa, una elettrovalvola oramai è chiusa, un laser è acceso, ecc.).

Passando per piani o livelli successivi, si arriva agli oggetti terminali quali fresa, pezzo da lavorare o manipolare, caustica laser, cianfrino, pinza, ecc. Tutti gli oggetti terminali sono aggiornati alla realtà concreta attuale.

Avendo, nel frattempo, costruito un altro modello di quegli stessi pezzi in una condizione o stato diverso e confrontandolo con il modello proveniente dalla realtà, troverò come risultato una serie di differenziali che andranno a costituire un fronte di riflesso verso il concreto. Questo nuovo fronte, generato dal confronto, attraverserà piani di disaggregazione fino ad Olocontrollo per poi entrare verso gli attuatori. Le azioni conseguenti determineranno un risultato tale che la configurazione concreta uguagli la nuova configurazione voluta e disegnata.

Da qui riparte un fronte di stati verso l’Emulatore attraverso Olocontrollo per ricostituire una nuova fase di inseguimento all’uguaglianza.

Sintesi sul riflesso dinamico

Proprietà caratteristica dell’emulatore è, quindi, quella di poter riversare contemporaneamente due o più scenari diversi all’interno dello spazio virtuale.

Ipotizziamo quindi di aver rilevato l’ambiente attraverso il sistema di percezione sensoriale della macchina e di averlo ricostruito virtualmente.

Ipotizziamo, inoltre di riversare nel sistema, in un istante successivo, un secondo scenario identico al precedente, con un fronte di ingresso identico al fronte precedente. I due scenari virtuali si trovano in equilibrio in quanto la differenza fra i due fronti corrispondenti è nulla. I canali sono liberi.

Ipotizziamo ora di modificare uno dei due scenari virtuali o apportando modifiche all’ambiente esterno o forzando all’interno uno scenario costruito con strumenti informatici convenzionali (programmi, tastiera, mouse).

Ora, i due scenari virtuali non sono più in equilibrio in quanto presentano differenze che si traducono (interferenze) in segnali inviati lungo i canali virtuali di uscita e poi lungo quelli reali. I relativi comandi attuatori interverranno sullo scenario reale modificandolo.

Gli aggiornamenti indotti sull’ambiente dai comandi attuatori del sistema rientrano in esso attraverso il proprio sistema di percezione. Si innesta così un riflesso dinamico di stati che realizza nel sistema quella sorta di “capacità riflessiva” di cui abbiamo parlato in precedenza. In altre parole, la realtà concreta e quella virtuale emulativa sono legate da una legge che tende all’uguaglianza o, meglio, di inseguimento reciproco, mediante la quale qualunque modificazione in uno qualsiasi degli ambienti, attraverso il riflesso dinamico, si riflette nell’altro. Ovvero, il mondo della “realtà concreta” si avvicina sempre più, fino ad eguagliarlo, al mondo della “realtà virtuale” dove si trova fin dall’avvio anche la condizione “obiettivale” (lo scenario costruito con strumenti informatici).

In questo modo, la “macchina”, completata della sua nuova sezione intelligente, autovaluta di volta in volta qualitativamente le proprie azioni verso un obiettivo ad essa assegnato.

L'”autonomazione”

Un apparato così costituito trasforma l’attuale standard convenzionale degli apparati di controllo delle macchine da “itineranti preprogrammati” ad “autodeduttivi”. Si passa così dal sistema detto “automazione” ad un sistema da noi definito “autonomazione”.

Cioè, con “l’automazione” è necessario preprogrammare la “macchina” registrando in essa il dettato, punto per punto, delle sue azioni che poi, “automaticamente” e “rigorosamente”, ripete tutte le volte in eguale maniera. Il sistema di tipo obiettivale non ha bisogno di conoscere preventivamente le operazioni elementari necessarie per raggiungere l’obiettivo, cosa peraltro necessaria nei sistemi convenzionali, non ha bisogno della completa e preventiva conoscenza del processo da controllare.

In questo caso con “l’autonomazione” basta descrivere alla “macchina” il solo obiettivo: essa provvede “autonomamente” ad organizzare e, quindi, ad utilizzare le proprie risorse per raggiungerlo, anche attraverso il superamento di eventuali ostacoli o condizioni estemporanee impreviste.

La modularità

La struttura parallela di Olocontrollo Emulativo e la formazione dei piani di trasduzione e di interferenza, che possiamo considerare verticalità del sistema (concreto/virtuale/concreto/virtuale ecc.) permette di moltiplicare il numero dei canali nella dimensione orizzontale. Tale caratteristica definisce la modularità intrinseca di Olocontrollo Emulativo. Ciò permette di considerare una macchina complessa come un gruppo di canali ingresso/uscita/ingresso/uscita. Ovvero, ad una macchina con n ingressi, gestita da Olocontrollo Emulativo, possono essere aggiunti altri canali od addirittura altre macchine, coi loro canali, senza che ci sia alcun rallentamento nel processo di inseguimento.

Concludendo, si giunge a definire che i fronti costituiti nel concreto dal piano delle interferenze operazionali (utensile che interferisce sul pezzo in lavorazione) e nel virtuale dal piano ove avviene la generazione dei differenziali di comando, costituiscono le superfici riflettenti adattative di una “cavità risonante” tendente alla stabilizzazione istante per istante.

Esempi di alcune macchine realizzate e corredate da Olocontrollo Emulativo

A cominciare dalle prime espressioni tecnologiche di Olocontrollo Emulativo e durante tutte le fasi del suo sviluppo, è stato particolarmente curato che esso fosse accompagnato parallelamente da un processamento industriale che rendesse costantemente sotto controllo l’applicabilità e la fruibilità. Fin dagli anni “ottanta” questa metodologia operativa ha permesso l’ottenimento di una chiara visione delle esigenze presenti e future provenienti dall’evoluzione tecnologica del mercato. Inoltre, questo modo di procedere ha permesso di produrre con metodi industriali una sorta di inseguimento applicazionale. D’altro canto, le ingenti somme di danaro e le risorse necessarie alla ricerca ed allo sviluppo che giungesse fino al mercato, non potevano essere reperite all’interno delle strutture ENEA. In ciò, siamo stati accompagnati costantemente dalla partecipazione, sia economica che in risorse tecniche, umane ed organizzative, da partner industriali. Ogni fase di avanzamento dello sviluppo di Olocontrollo Emulativo ha dato luogo, di fatto, ad una o più applicazione industriale finita. Di volta in volta, il Partner Industriale coinvolto, ha prodotto una macchina, un apparato, un servizio, che un cliente ha acquisito ed utilizzato. Proprio tali acquisizioni da parte di utilizzatori finali, ha reso possibile i movimenti di capitali necessari allo sviluppo.

Nel quadro generale dell’organizzazione, una nota importante è costituita dal rapporto tra le quantità di risorse umane disposte da ENEA e quelle disposte dai vari Partner coinvolti. Questo rapporto risulta essere mediamente di “uno a dieci”, con picchi di “uno a quindici”.

Con questa metodologia, intendiamo procedere ulteriormente, attraversando le ulteriori tappe della ricerca e degli sviluppi necessari.

Di seguito citiamo conclusivamente alcuni esempi di applicazioni industriali ultimamente realizzate. Da ricordare che tali avanzamenti hanno nel loro interno e necessitano di quanto si va progredendo nella ricerca teorica e di laboratorio.

|

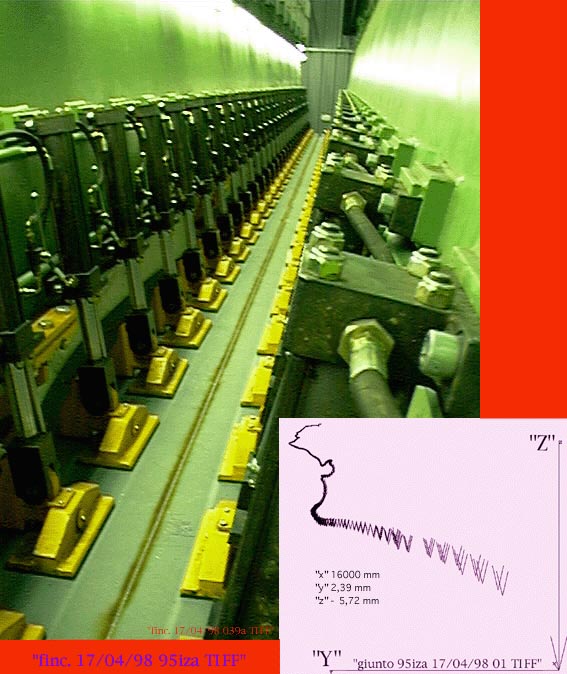

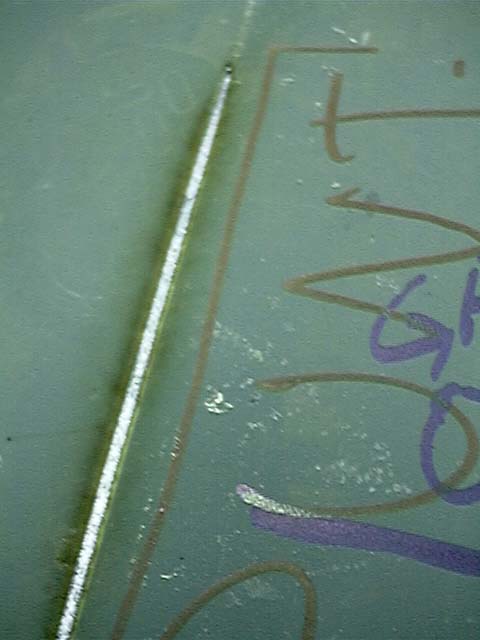

Macchina Laser per la saldatura di lamiere per la cantieristica navale controllate con anello visivo per l’inseguimento del giunto di saldatura di lunghezza fino a 16 metri. La macchina è attualmente in fase di inserimento nella catena di produzione nella linea “Grandi Navi da Crociera” nei Cantieri Fincantieri di Monfalcone.

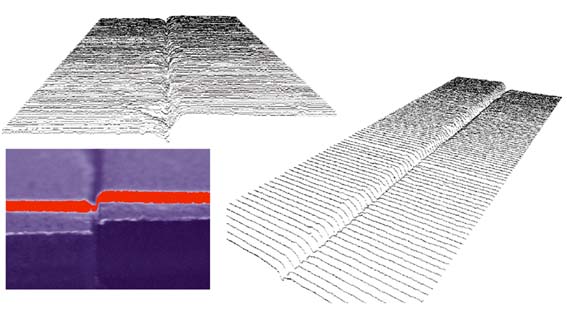

In figura: Cordone di Saldatura (16 metri di lunghezza)realizzato con l’andamento del giunto di saldatura rilevato con il dispositivo di visione artificiale “visio”. |

|

|

Esempio di virtualizzazione di giunti di saldatura | |

|

Porzione di saldatura realizzata | |

|

Macchina Laser Fincantieri mentre lavora | |

|

Macchina Laser Fincantieri vista dall’esterno | |

|

Transfer a Sette Centri di Lavoro più Carico e Scarico con manipolatore guidato da visione artificiale “visio”. Complessivamente 44 assi. | |

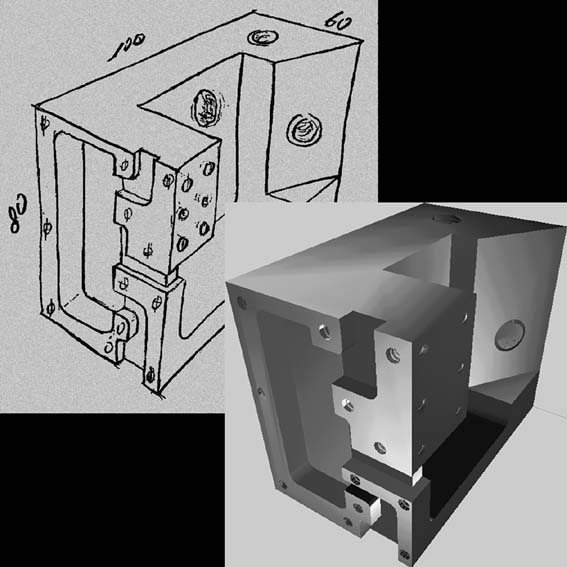

|

Dallo “schizzo” del pezzo al suo “virtuale” con visualizzazione resa con “rendering” | |

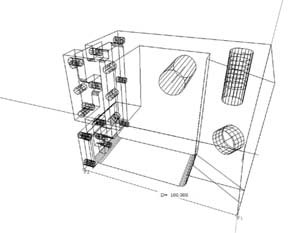

|

Puro “virtuale” realizzato con lo strumento di virtualizzazione di Olocontrollo Emulativo | |

|

Macchina per la formatura degli “Stent Coronarici” a partire dal filo di acciaio inossidabile | |

|

Stent chiuso all’uscita della macchina | |

|

Stent espanso come quando nel vaso sanguigno di destinazione |

|

Copyright © 2015 Controluce - link a Notizie in... Controluce - link al sito dell'ENEA |

|